Une étude indique que les humains auraient développé des systèmes neuronaux complémentaires d’interprétation des stimuli auditifs dans chaque hémisphère

La parole et la musique, deux activités fondamentalement humaines, sont décodées chacune par un hémisphère différent du cerveau. Une nouvelle étude a utilisé une approche unique pour expliquer cette spécialisation.

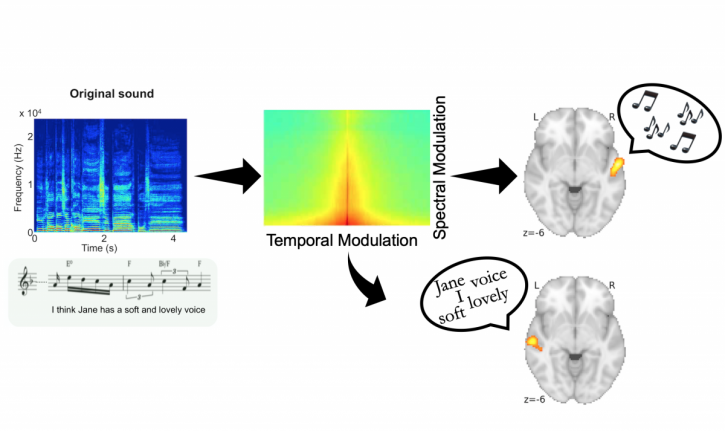

Des chercheurs du Neuro (Institut-Hôpital neurologique de Montréal de l’Université McGill) ont enregistré séparément 100 phrases chantées a capella par une soprano, puis ont déformé les enregistrements selon deux dimensions auditives fondamentales : la dynamique spectrale et la dynamique temporelle. Ils ont ensuite demandé à 49 participants de reconnaître le texte ou la mélodie de chaque chanson. L’expérience a été menée sur deux groupes, un francophone et un anglophone, afin d’améliorer la reproductibilité et la généralisabilité des résultats. Cliquez ici pour écouter une démonstration de l’expérience.

Les chercheurs ont constaté que pour les deux langues, lorsque l’information temporelle était déformée, les participants avaient du mal à reconnaître les paroles, mais pas la mélodie. À l’inverse, lorsque l’information spectrale était déformée, ils avaient du mal à reconnaître la mélodie, mais pas les paroles. Cela montre que paroles et mélodie dépendent de caractéristiques acoustiques différentes.

Pour tester la réaction du cerveau à ces différentes caractéristiques, les chercheurs ont soumis les participants à un examen d’imagerie par résonance magnétique fonctionnelle (IRMf) durant lequel ils leur ont demandé de différencier des sons. Ils ont découvert que le traitement de la parole était associé au cortex auditif gauche, et le traitement de la mélodie, au cortex auditif droit.

Ensuite, ils ont cherché à comprendre l’incidence de la dégradation de chaque dimension acoustique sur l’activité cérébrale. Ils ont découvert que la dégradation de la dimension spectrale n’affectait que l’activité du cortex auditif droit, et seulement pendant le traitement de la mélodie, tandis que la dégradation de la dimension temporelle n’affectait que le cortex auditif gauche, et seulement pendant le traitement de la parole. Ainsi, la réponse différentielle dans chaque hémisphère dépend du type d’information acoustique perçu.

Des études antérieures sur les animaux ont montré que les neurones du cortex auditif réagissent à des combinaisons précises d’énergie spectrale et temporelle, particulièrement aux sons pertinents pour l’animal dans son environnement naturel, comme ceux associés à la communication. Pour l’humain, la parole et la musique sont des moyens de communication importants. Cette étude montre que toutes deux exploitent différentes extrémités du continuum acoustique spectrotemporel, et que la spécialisation hémisphérique pourrait permettre au système nerveux d’en optimiser le traitement.

« On sait depuis des décennies que les deux hémisphères réagissent différemment à la parole et à la musique, mais le fondement physiologique de cette différence restait un mystère, explique Philippe Albouy, auteur principal de l’étude. Nous avons montré qu’elle est liée à des paramètres acoustiques de base pertinents pour l’interprétation de la parole et de la musique. Ces résultats viennent enrichir les connaissances de base de l’organisation neurale. »

National Public Radio | How the brain teases apart a song’s words and music

Cosmos Magazine | Even if the song is simple, listening to it is complex

Le 28 février 2020